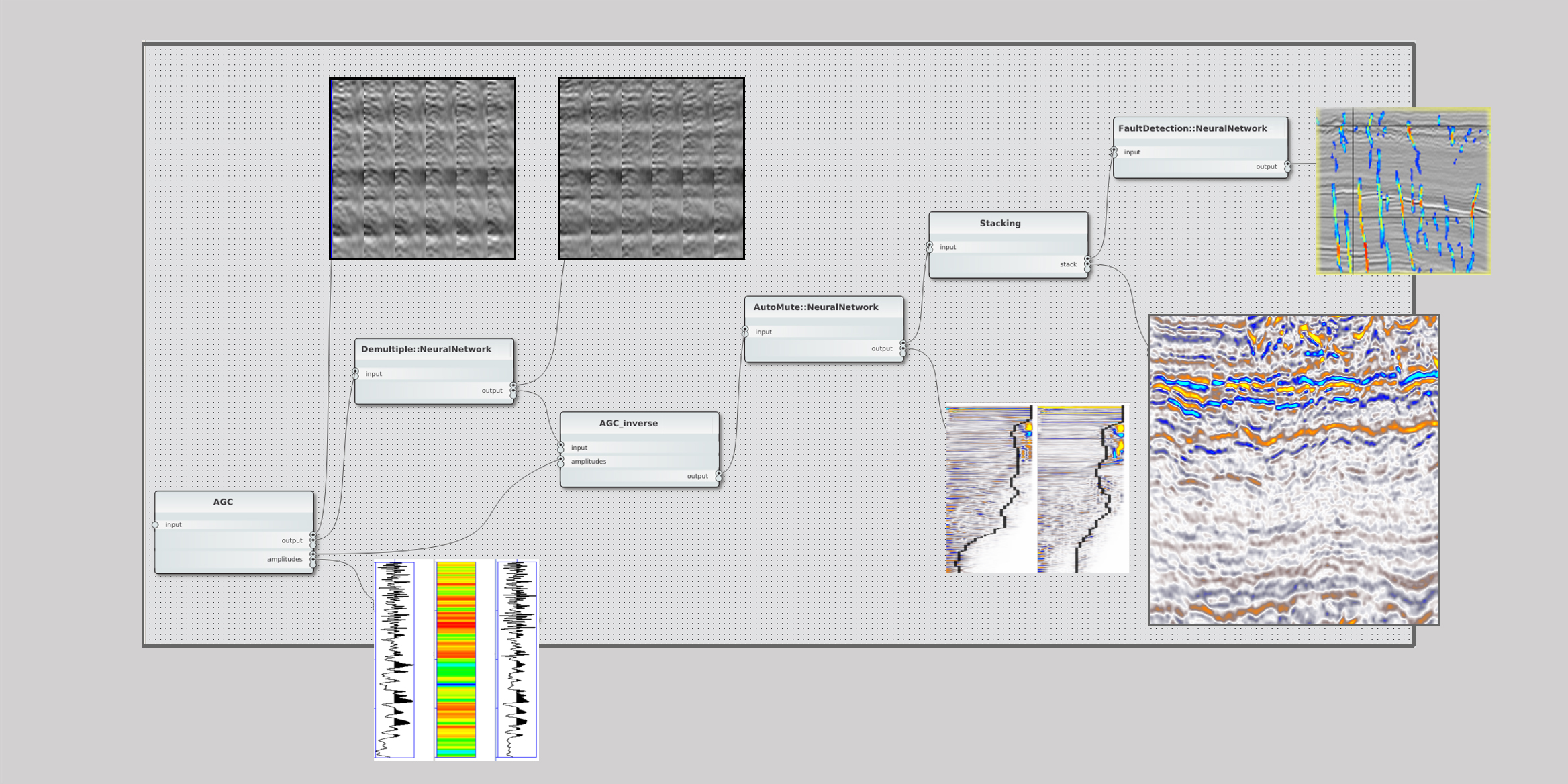

Komplexe Rechenoperationen auf wachsenden Datenmengen kennzeichnen die Herausforderungen der seismischen Datenverarbeitung. ALOMA ist eine fehlertolerante Laufzeitumgebung, die bei der Bewältigung dieser Problemstellung unterstützt und es ermöglicht, seismische Anwendungen effizient auf großen verteilten Systemen laufen zu lassen. Da die zu untersuchenden Bereiche immer größer werden, müssen sich auch die Systeme anpassen und immer größere Datenmengen verarbeiten. Die effiziente Nutzung verteilter Ressourcen wird daher hier immer wichtiger.

Dies zwingt Geophysiker:innen dazu, sich HPC-Wissen anzueignen, damit ihre Software auch auf großen Systemen effizient läuft. Mit ALOMA können sie sich weiter auf ihre Kernkompetenz konzentrieren und müssen sich nicht um Parallelisierung, Multithreading und andere Herausforderungen des High Performance Computings kümmern. Die effiziente Ausführung der Algorithmen, auch auf großen und heterogenen Systemen, übernimmt dann unser Softwaresystem.