Künstliche Intelligenz (KI) und Maschinelles Lernen (ML) sind längst in vielen Produkten und Prozessen angekommen – doch das Potenzial ist bei weitem nicht ausgeschöpft. Zahlreiche Anwendungen warten noch darauf, erschlossen zu werden.

Unsere Stärken:

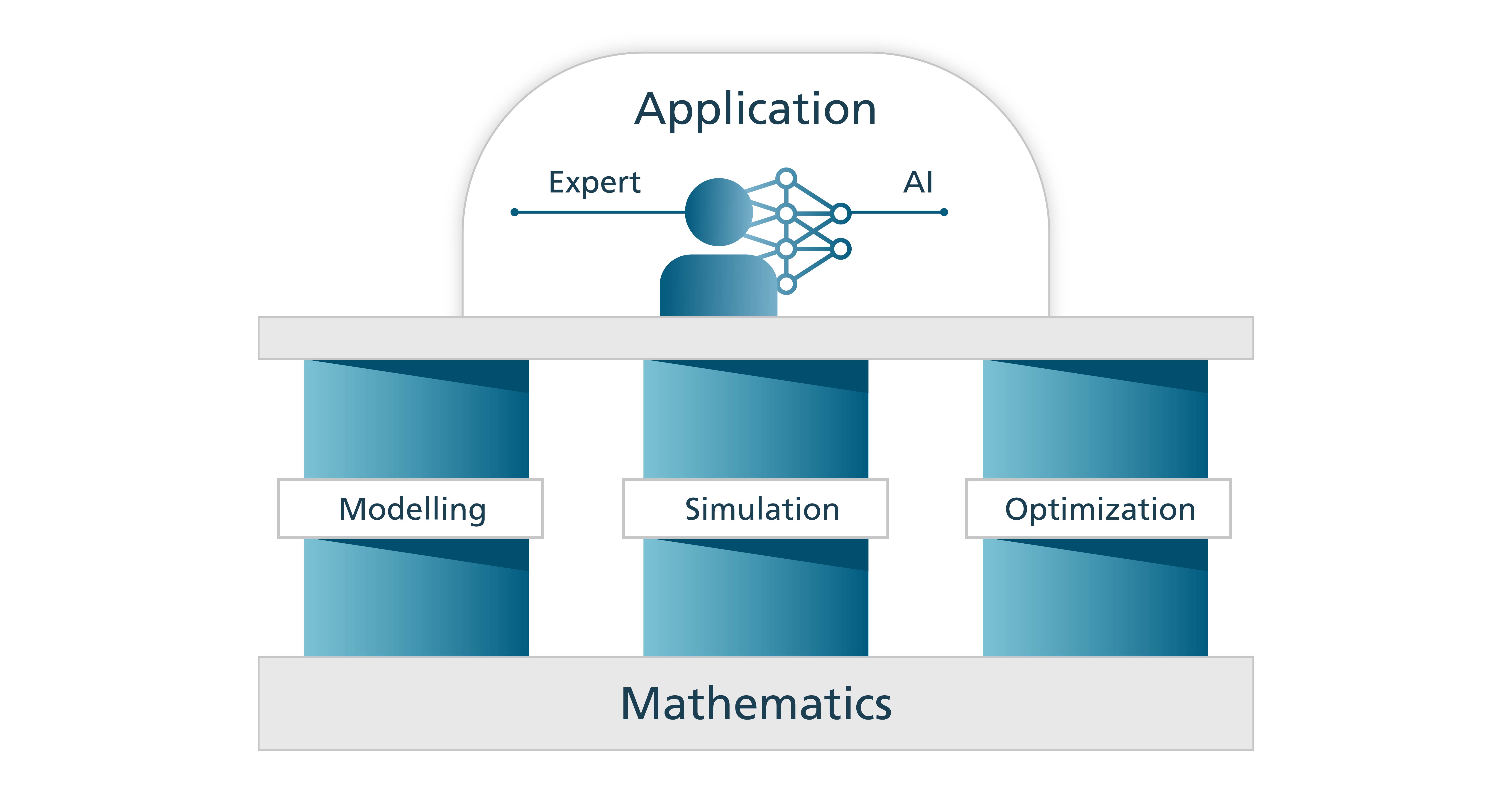

- Wir haben ein tiefes mathematisches Verständnis von KI-Algorithmen.

- Wir kombinieren KI mit Wissen von Expertinnen und Experten.

- Wir integrieren KI optimal in Anwendungen der Modellierung, Simulation und Optimierung.