Durch die Verfügbarkeit großer Datenmengen und die Fortschritte bei der Rechenleistung hat sich Deep Learning (DL) als bahnbrechende Technologie für viele der schwierigsten Probleme in der Sprachverarbeitung, der Bildverarbeitung und Computerlinguistik etabliert. Die gelernten Ansätze sind inzwischen den herkömmlichen überlegen – sei es in Genauigkeit, Durchsatz oder Flexibilität. Viele Herausforderungen in den Geowissenschaften basieren genau auf diesem Bedarf: wissenschaftliche Erkenntnisse aus einer schnell wachsenden Menge verfügbarer synthetischer, beobachteter und experimenteller Daten zu gewinnen.

Projekt DLseis – Deep Learning for Large Scale Seismic Applications

Deep Learning für groß-skalige seismische Anwendungen

Das interdisziplinäre Projekt »Deep Learning für groß-skalige seismische Anwendungen« (DLseis) geht systematisch diese Herausforderungen an. DLseis kombiniert dabei unsere Kompetenzen in den Bereichen Seismik, Hochleistungsrechnen und Maschinelles Lernen (ML), um klassische Implementierungen von Komponenten seismischer Arbeitsabläufe durch ML-Ansätze zu ersetzen. Besonderes Augenmerk legen wir dabei auf Anwendungen, die sich in der Praxis als zeitaufwändig, fehlerbehaftet und als zu stark abhängig vom subjektiven Beurteilen der Bearbeitenden erwiesen haben.

- Die erste Phase von DLseis wurde in den Jahren 2019 bis 2021 erfolgreich umgesetzt. Siehe die Arbeitspakete und einige Highlights im Abschnitt »Phase 1«.

- DLseis Phase Zwei ist derzeit im Gange. Informationen dazu erhalten Sie im Abschnitt »Phase 2«.

Die Forschungsinhalte der ersten Phase waren in drei Themenblöcke eingeteilt:

- Grundlagenforschung zu Deep-Learning-Methoden

- Weiterbildung und Ausbildung

- Seismische Anwendungen: Einsatzbereite Software für die Produktion

Erste Phase abgeschlossen

Grundlagen: Anwendungsorientierte Forschung

Wir berichteten über Entwicklungen in:

- Skalierbares Trainieren großer DL-Modelle auf HPC Rechenclustern. Für seismische Anwendungen müssen die Modelle anhand sehr großer Prestack-Datensätze trainiert werden. Aktuelle Deep Learning Software erlauben nicht das dazu notwendige Maß an Parallelisierung. Daher haben wir einen Fokus unserer Forschung auf skalierbare DL-Rahmensoftware gelegt → Produkte: Tarantella, Carme

- Optimales Netzwerkdesign durch automatisierte Parametersuche → DeTol

- Untersuchungen zur Übertragung von GANs in ihrer Eigenschaft, Datensätze einander anzugleichen, für seismische Anwendungen → Publikationen zu Boulder-/Diffraktionserkennung und Horizontinterpretation

Ausbildung und Weiterbildung

Eine der größten Herausforderungen im Deep Learning ist es, mit der Geschwindigkeit der Entwicklungen Schritt zu halten. Täglich werden Hunderte neuer Forschungsergebnisse publiziert. Wir haben daher ein Informationssystem für das Konsortium aufgesetzt, in dem interessante Publikationen und Resultate zusammengestellt und kommentiert werden. Darüber hinaus wurden zweimal im Jahre Workshops für Konsortialmitglieder:innen abgehalten (Orte: Houston und Berlin).

Seismische Anwendungen: Einsatzbereite Deep-Learning-Tools

Eine Sammlung anspruchsvoller Schlüsselanwendungen in der seismischen Datenverarbeitung überträgt unsere Grundlagenforschung auf einsatzbereite Werkzeuge. Wir haben an den folgenden Themen gearbeitet:

- Auto-mute: Muten von seismischen Gathers für optimales Stapeln und Löschen irrelevanter Amplitudeninformation. Dazu: Entwicklung eines Werkzeugs zum Labeln von Datensätzen und eines aktiven gewarteten Systems zum fortgesetzten Trainieren von Netzwerken bei Hinzufügen von neuen Trainingsdatensätzen.

- Detektion geologischer Störungen. Dazu: Entwicklung eines synthetischen Modellierungstools für die Erzeugung seismischer Migrations-Ergebnisse bei Vorliegen von Störungen. Visualisierung des Gradiententerms für die Netzwerkanalyse und damit verbessertes Netzwerkdesign.

- Dip-filter für Stacks und Offset-plane Daten; Einbau eines Schutzes zur Bewahrung von Reflektionen von Störungsflächen.

- Studie zum AVO-Potenzial eines Datensatzes durch ML-Cluster-Techniken.

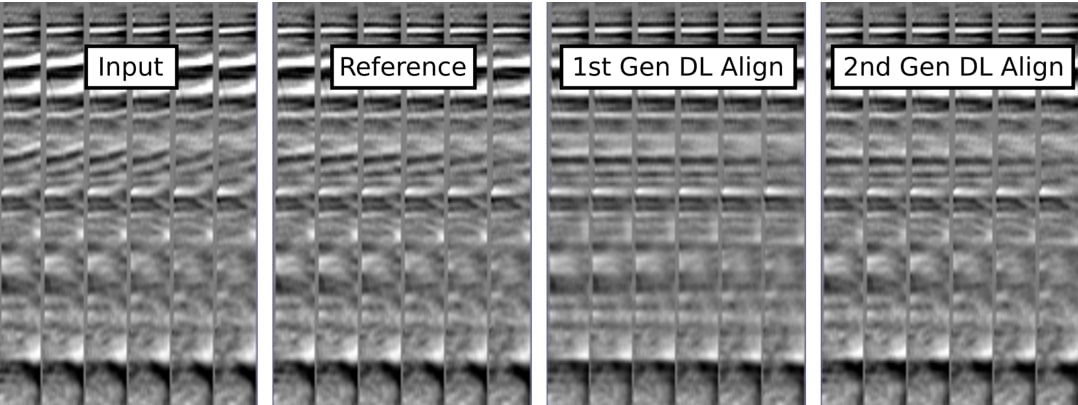

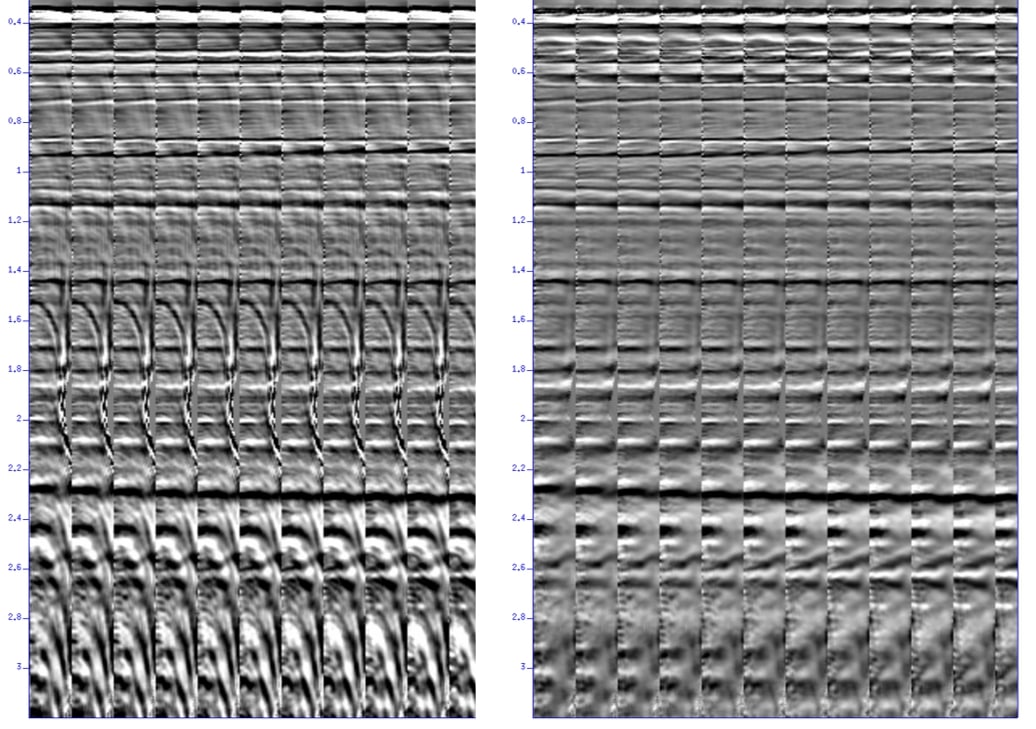

- ML-Align und -demultiple für Gathers in einem Bild-zu-Bild Modus; Entwicklung des Dual-Use Konzeptes für die Wiederverwendung von Netzwerkdesigns bei geänderten synthetischen Trainingsdaten; Untersuchungen zur herausragenden Rolle synthetischer Datensätze beim Trainieren der Netzwerke in der Seismik → Game-Changer-Potenzial für die Post-Migration-Prestack-Gather-Konditionierung (Abbildungen 1 und 2).

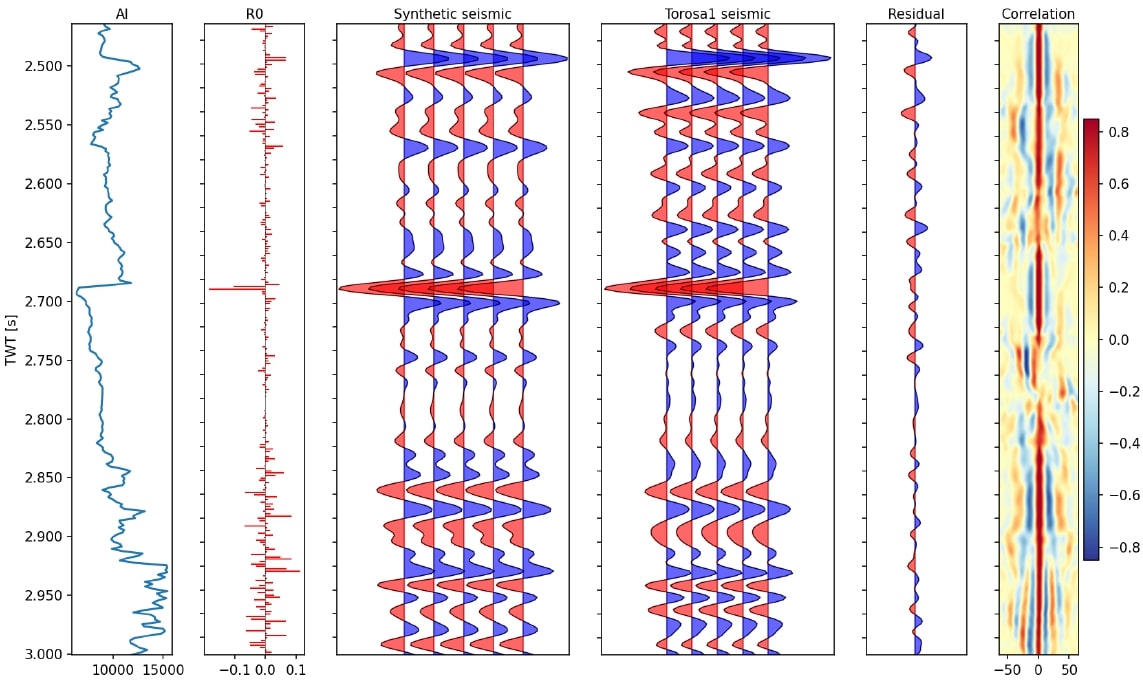

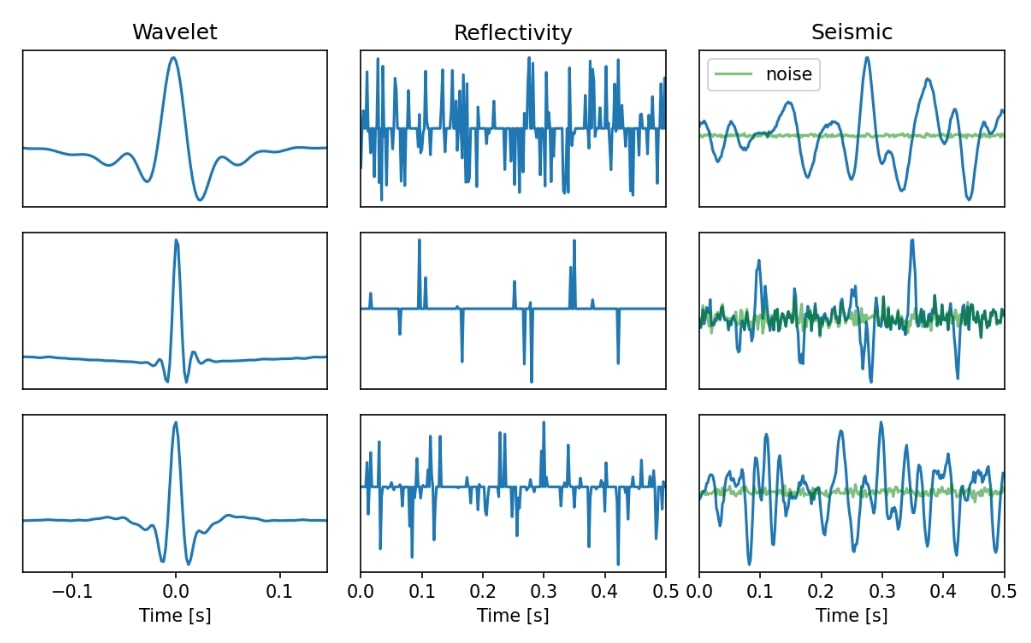

- Halbautomatischer Well-tie (Abbildung 3): DNN-basierte Wavelet-Extraktion (Abbildung 4), eingebettet in eine Bayes'sche Parameter-Suchstrategie für die Anpassung der Zeit-Tiefen-Tabelle und das Editieren der Bohrlochdaten. Minimale Benutzerinteraktion und Vorteile bei kurzen Bohrlochsegmenten.

Erfolgreiche Tools wurden in das Auto-Paralleliersungsframework Aloma integriert. Komplexe Arbeitsabläufe für ML-Anwendungen von trainierten DNNs können mit dieser Software effizient entworfen und ausgeführt werden. Das Bearbeiten von Gathern und Stacks ist kombinierbar. Große Datenblöcke können aufgeteilt, separat bearbeitet und zu den finalen Ergebnissen zusammengefügt werden.

Als Kommunikationsformat zwischen Python-gesteuertem Netzwerk-Design und und Netzwerk-Trainings einerseits – ausgeführt auf unserem hauseigenem GPU-Cluster – und der Anwendung auf reale Felddaten andererseits, verwenden wir ONNX (Open Neural Network Exchange). Die Aufgaben des seismischen Multiplenentfernens und der Trimstatikkorrektur reduzieren sich somit auf das Einspeisen der zu bearbeitenden Daten in das für die jeweilige Anwendung trainierte ONNX Netz. Die gewünschten Ergebnisse werden einfach durch Abgreifen der Daten aus der letzten Netzwerkschicht erhalten. Eine solche Datenverarbeitung ist völlig parameterfrei!

Bisherige Projektpartner und Danksagung

Die folgenden Energieunternehmen unterstützten die erste Phase des Projektes. Für ihre finanziellen Förderung, die zur Verfügung gestellten Datensätze und ihre Teilnahme an konstruktiven und motivierenden Projektmeetings danken wir herzlich.

- ConocoPhillips

- Equinor ASA

- Exxon Mobil Corporation

- Hess Corporation

- MOL-Norge

- Wintershall Dea

Zweite Phase: DLseis geht in die nächste Runde

Dieses Projekt wird als Erweiterung für einen Zeitraum von weiteren zwei Jahren aufgesetzt und zielt insbesondere auf Anwendungen von Machine Learning ab, bei denen gegenüber den klassischen Ausführungen durch ML klare Vorteile zu erwarten sind. Wir setzen dabei (wie in der ersten Phase) weitgehend auf Themen, die nicht bereits durch andere Forschergruppen abgedeckt sind. Die Themenauswahl beruht auf den Arbeiten der ersten Phase.

Hier haben wir erfolgreich das Feld der Deep Neural Networks (DNNs-) gestützten Bild-zu-Bild-Verarbeitung besetzt. Wir beobachteten eine hohe Qualität der Anwendungsergebnisse für eine Vielzahl seismischer Datensätze – auch wenn die Netze ausschließlich mit rein synthetischen Daten trainiert worden waren. Eine wesentliche Erkenntnis hierbei war die Abstraktionsebene für die synthetischen Datensätze, die eine merkmalsorientierte Modellierung erforderte, ohne die Notwendigkeit, das reale Aussehen der Felddaten zu simulieren.

Besondere Möglichkeiten der neuen ML-Tools nutzen

Werkzeuge zur Gather-Konditionierung – wie ML-Demultiple und ML-Align – zeigen klare Vorteile gegenüber klassischen Methoden:

- Vermeidung von Parametern zum Steuern der Prozesse

- Unabhängigkeit von der jeweiligen Domäne der Gather (Zeit-Tiefe, Offset-Winkel)

- Deutliche Beschleunigung der Prozessabläufe durch die obsolet gewordene Qualitätskontrolle

- Vermeidung von typischen Artefakten der klassischen Ergebnisse, wie z.B. oszillierende künstliche Strukturen, die durch Align verursacht werden, oder falsches Amplitudenentfernen aufgrund von RMO-starken Aliasing-Ereignissen in Radon-Demultiple

Das Potenzial dieser Werkzeuge in hochwirksame Alternativen zu klassischen Methoden ist damit offensichtlich. Klar ist auch, dass wir das erforderliche Maß an Robustheit und Qualität nur durch eine enge Zusammenarbeit mit Industriepartnern erreichen. Dabei beziehen wir deren Datensätze und Fachwissen bei der Bewertung der Ergebnisse mit ein. Technisch wurde diese Zusammenarbeit in der ersten Phase durch die Integration der Werkzeuge in die Ausführungsplattform Aloma vorbereitet. Aloma wurde erfolgreich bei den Partnern installiert und von den Unternehmen bereits versuchsweise genutzt.

Die Aufgaben und Ziele für die zweite Phase sind entsprechend dieser Vorarbeiten und dem Kompetenzprofil festgelegt und werden am Fraunhofer ITWM von einer Arbeitsgruppe mit Expertise in den Bereichen Seismik (Processing und Interpretation), HPC und ML bearbeitet.

Die geplanten Arbeitspakete umfassen:

- Erweiterung der Gather-Konditionierung

- AVO-Inversion

- Nutzung von GANs für seismische Anwendungen

- Interpolieren seismischer Daten in unterschiedlichen Sortierungen

- Studie zum Training mit synthetischen Daten im Vergleich zum Training mit gelabelten Felddaten

- automatisierte Multi-Well-Tie

Kontaktieren Sie uns gerne, wenn Sie den vollständigen, englischsprachigen Projektvorschlag (Proposal) erhalten möchten.