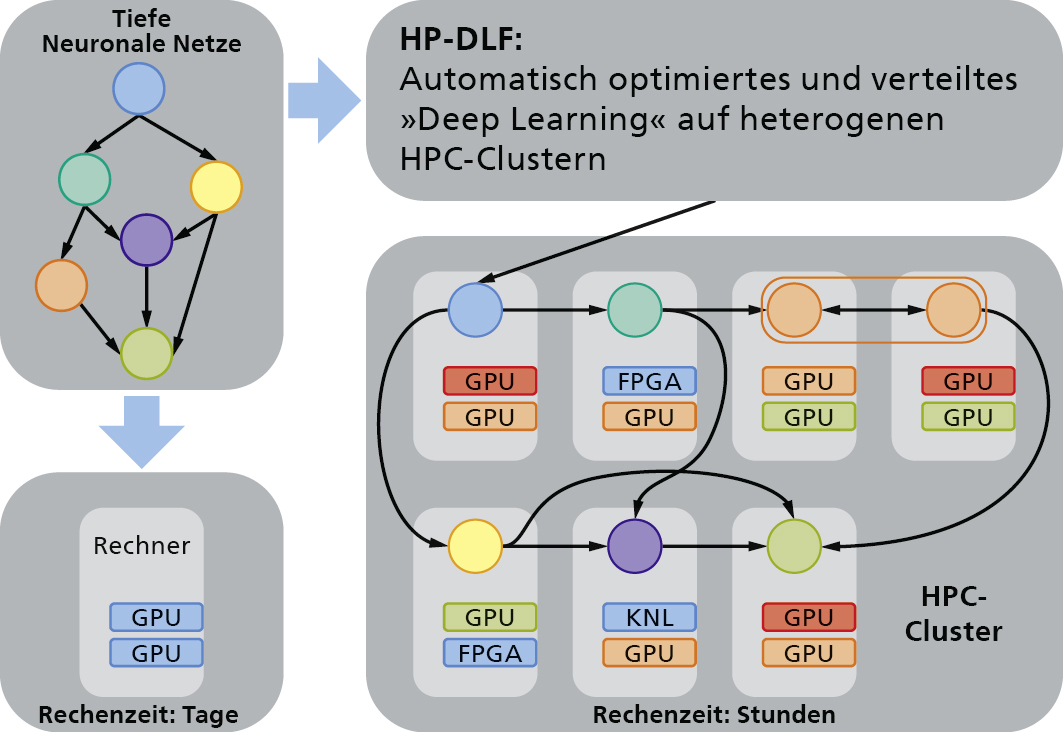

Im BMBF-Projekt »High Performance Deep Learning Framework« (HP-DLF) wird Wissenschaftlerinnen und Wissenschaftlern sowie Entwicklerinnen und Entwicklern aus dem Bereich »Deep Learning« ein einfacher Zugang zu existierenden und zukünftigen Hochleistungsrechensystemen ermöglicht.

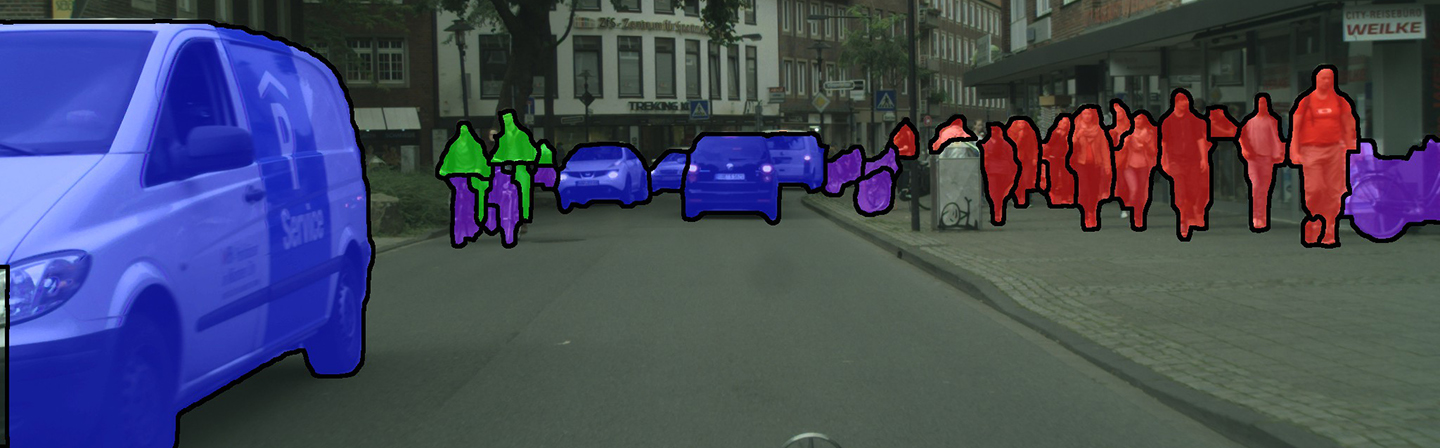

Wie erkennt ein autonom fahrendes Auto Fußgänger und andere Verkehrsteilnehmer? Wie funktioniert alltagstaugliche Spracherkennung? Wie erkennt die Internet-Suchmaschine Personen auf Fotos? Die Antwort lautet: mit Machine Learning Algorithmen. In den letzten Jahren wurde im Bereich des Maschinellen Lernens erhebliche Vorschritte erzielt. Ein bedeutender Anteil dieser Erfolge ist auf die Weiterentwicklung von sogenannten »Deep Learning« Algorithmen zurückzuführen.

Im Zuge dieser Entwicklung werden heute immer größere und komplexere künstliche Neuronale Netze entworfen und trainiert. Diese für viele praktische Anwendungen erfolgreiche Vorgehensweise erfordert allerdings einen enormen Rechenaufwand und sehr viel Trainingsdaten. Daher hängt die weitere Entwicklung von »Deep Learning« wesentlich an der Entwicklung von Methoden und Infrastrukturen, welche auch zukünftig die Berechenbarkeit immer komplexerer Neuronaler Netze sicherstellen.

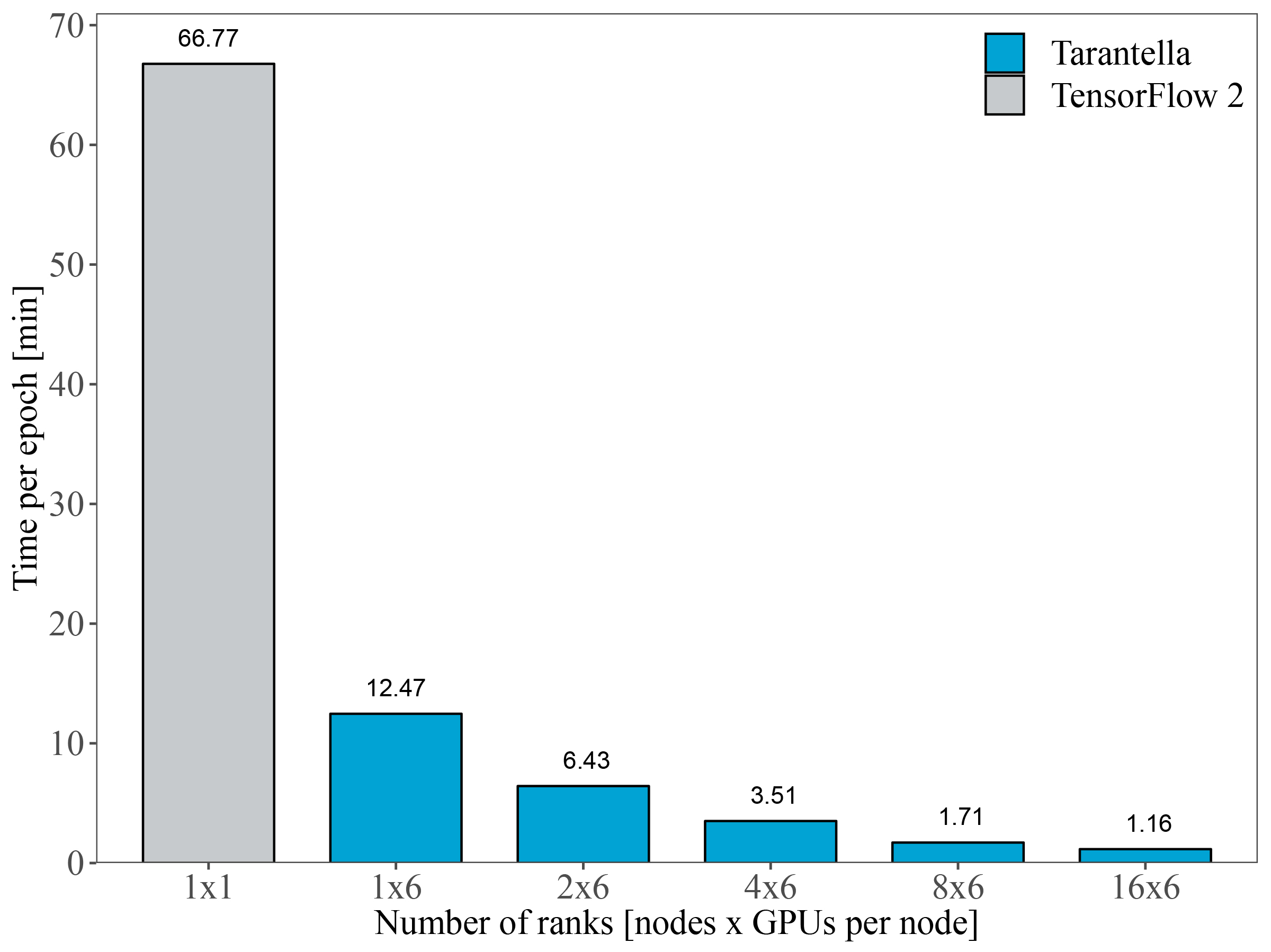

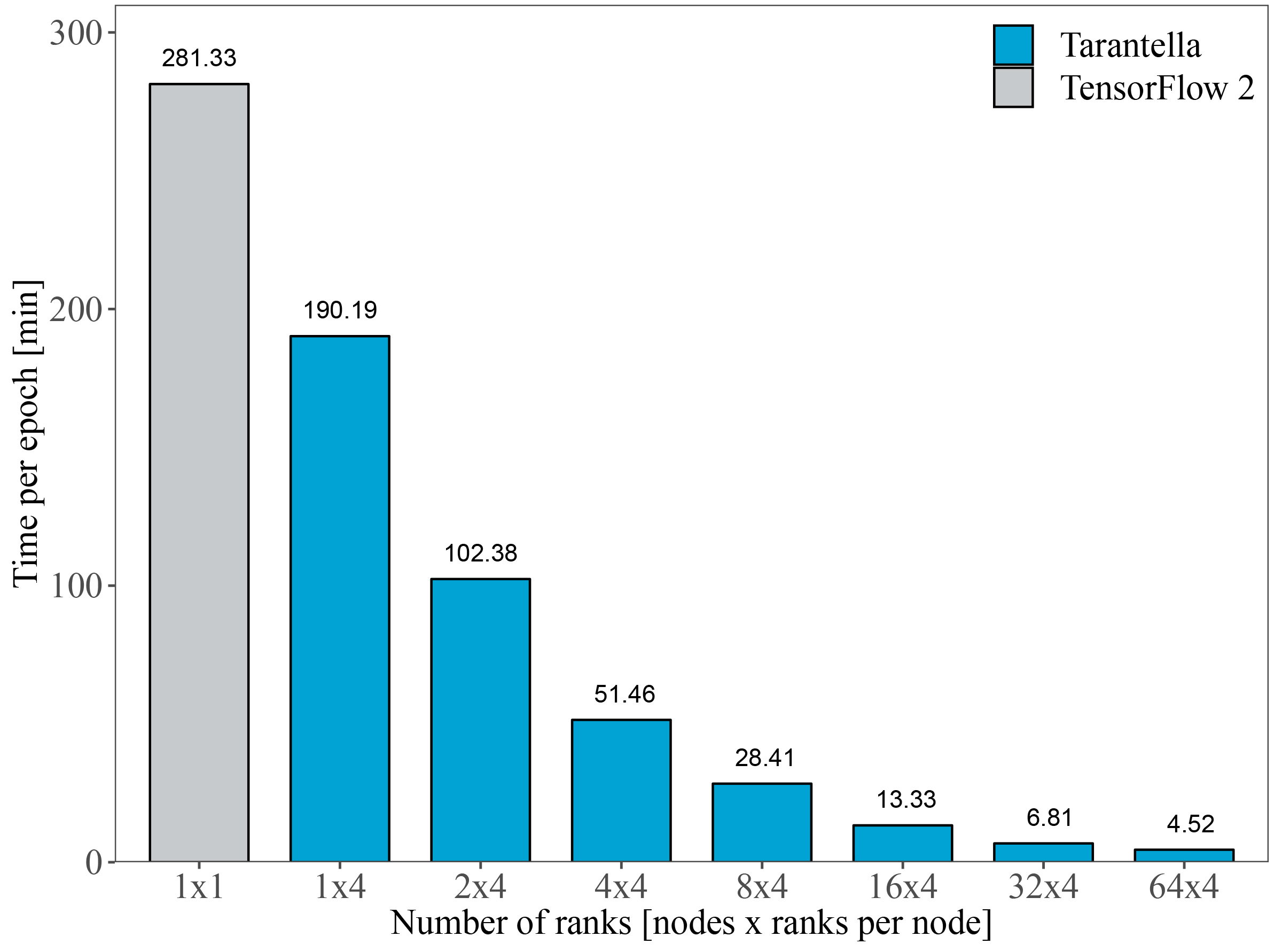

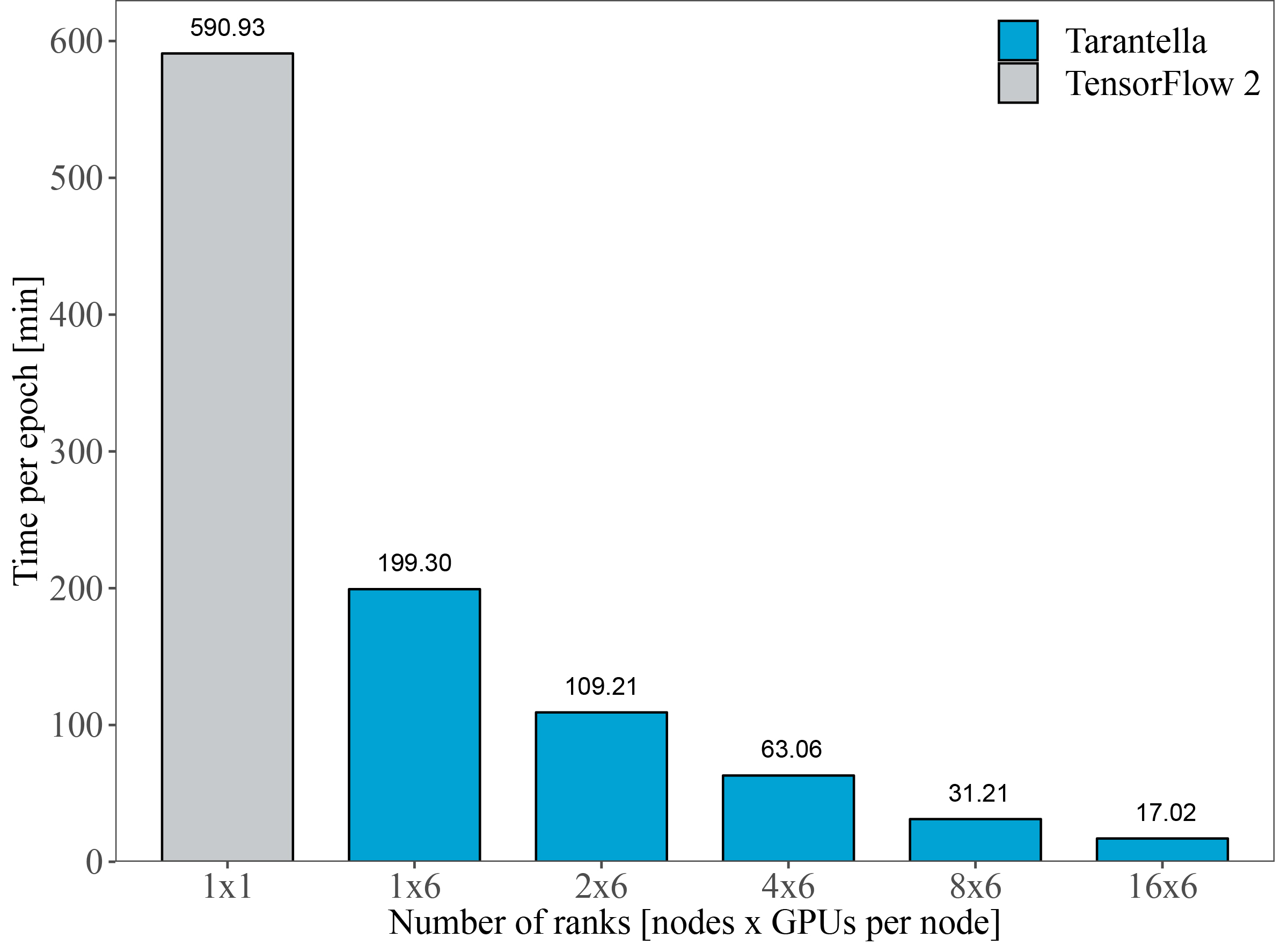

Im Rahmen von HP-DLF haben wir das open-source Framework Tarantella entwickelt, das auf hochmodernen Technologien sowohl aus dem Bereich des Deep Learnings als auch aus dem Bereich HPC aufbaut und das skalierbare Training von Deep Neural Networks auf Supercomputern ermöglicht.